ChatGPT : mentita sunt oracula !

Il y a quelque temps, j’avais commis un article du genre humoristique sur un modèle de langage à la mode (GPT-3) intitulé « GPT-3, le “language generator” qui fait parler les curieux ». Avec ChatGPT, on les fait même écrire ! Sauf que, maintenant, on ne rigole plus.

L’IA en mode « verbose »

Le mode verbose, en informatique, c’est celui qui dit ce qu’il est en train de faire. Une compilation bavarde, si vous voulez. Ici, c’est plutôt d’IA verbeuse qu’il est question. ChatGPT est une interface conversationnelle, pour l’instant gratuite, mise à disposition du public par OpenAI, par laquelle vous pouvez essayer ce nouveau modèle de langage spécialement entraîné pour simuler une interaction proche du dialogue.

D’un point de vue technique, le fonctionnement de ce générateur de langage pourrait se résumer à « toujours plus de la même chose ». OpenAI donne d’ailleurs quelques indications, sur le site dédié, sur la manière dont a été conçu le modèle : un joyeux mélange des techniques actuelles. Les modèles de langage à base de deep learning peuvent être dits auto-supervisés : les architectures de transformers (le T du GPT) s’entraînent sur des corpus de textes pour former des représentations vectorielles de mots ou de concepts. ChatGPT repose ainsi sur le modèle GPT dans sa version 3.5. Par-dessus, afin de spécialiser le modèle pour la génération de textes simulant un dialogue avec son interlocuteur, OpenAI indique avoir utilisé de l’apprentissage supervisé (des êtres humains ont présenté les réponses attendues) ainsi que de l’apprentissage par renforcement (une technique appartenant à la famille des apprentissages supervisés).

Tous ces apprentissages et optimisations ont été réalisés sur des supercalculateurs Microsoft (ça leur fait de la pub…) et le dernier-né d’OpenAI est prêt à éblouir son public. Verdict ?

L’Homme et la Bête

Beaucoup de bruit autour de la sortie de ChatGPT, à tel point que de nombreux journaux s’en sont fait l’écho. Ils ont testé… et le Dieu Ordinateur a répondu. Quoi donc ? Pour le savoir, nous avons testé aussi.

S’adressant à la machine comme si elle était une personne, on demande au programme de rédiger un courrier faisant état d’un mécontentement envers un service client. On obtient une prose répondant parfaitement à la requête. On demande alors à ChatGPT de corriger sa réponse en utilisant un ton plus virulent, et on obtient à nouveau un texte satisfaisant. Première remarque : on constate bien une fonction de dialogue, la machine gardant en mémoire la première requête sans qu’il soit nécessaire de repréciser la commande dans la seconde.

Autre essai : on rentre une phrase assez longue contenant diverses informations, et l’on questionne ChatGPT sur son contenu. Là encore, l’ordinateur répond convenablement, en utilisant des phrases appropriées. La prouesse est toutefois relative, car les réponses se basent sur les informations que l’on a données dans la phrase rentrée initialement. Sur cet exemple, on conclut que la machine est plutôt bonne en logique.

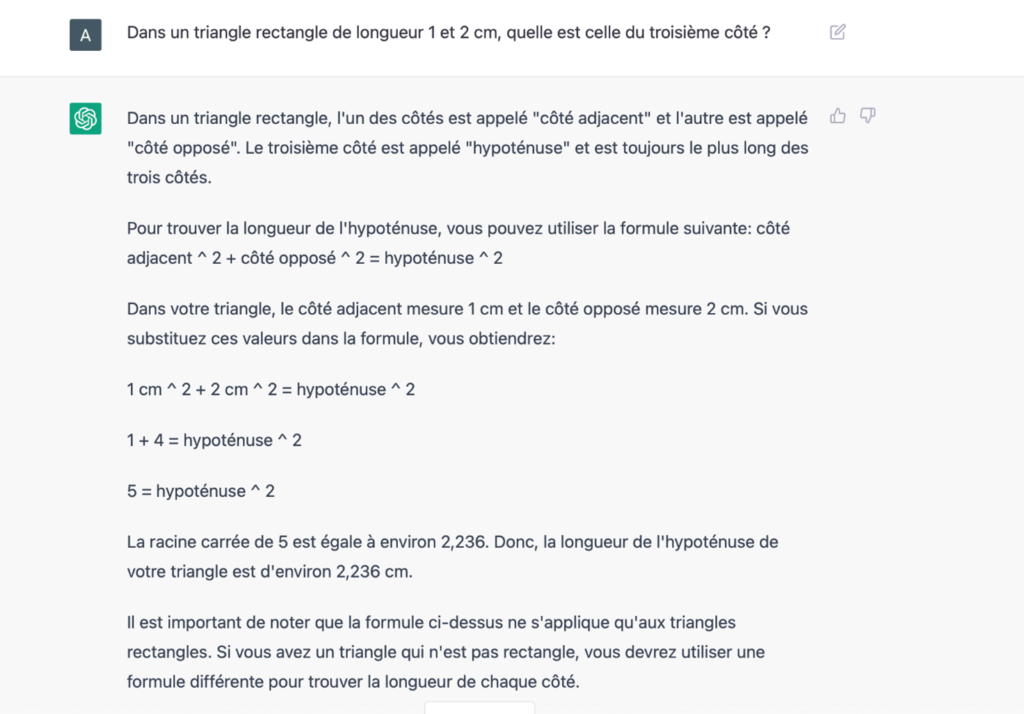

Enhardis par ces succès, nous décidons de pousser ChatGPT dans ses retranchements avec un petit problème de calcul dans un triangle rectangle. On donne très peu d’informations dans la phrase rentrée et le résultat est assez bluffant.

On raffine alors en changeant un peu les termes du problème : ce n’est pas l’hypoténuse que l’on cherchait à calculer, mais un des deux autres côtés.

La réponse est encore une fois parfaitement exacte et bien rédigée. Un léger malaise commence à apparaître : certains collégiens ne seraient pas capables de résoudre le même problème, et encore moins d’en rédiger convenablement la solution (même lorsqu’ils ont connaissance du théorème de Pythagore…).

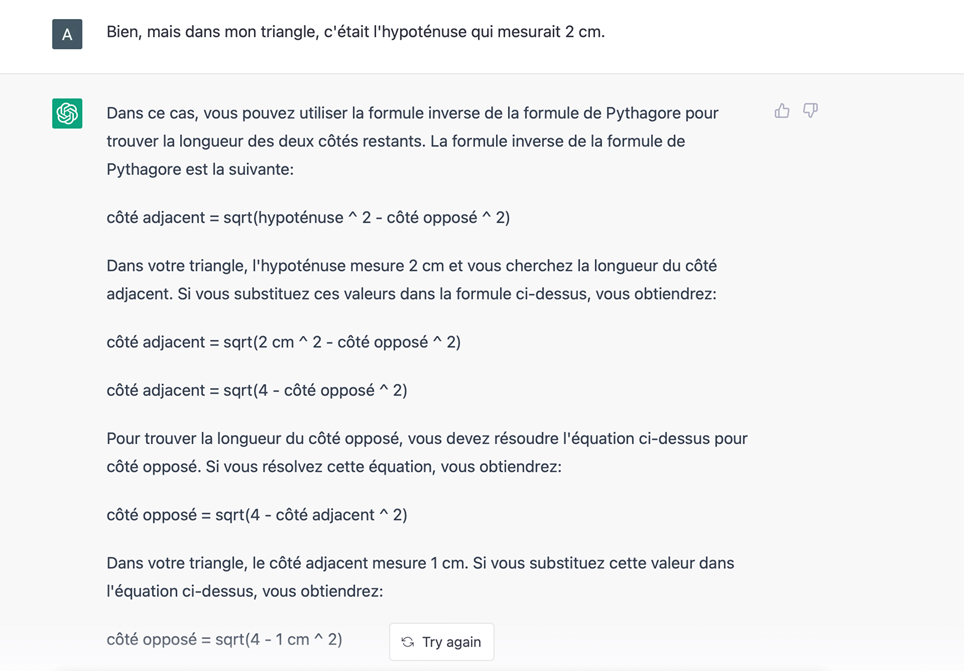

Très bien, ChatGPT sait lire, écrire et compter, mais qu’en est-il de ses connaissances en matière de ce que le monde entier nous envie : la Littérature Frrrançaise ?! (Ah oui, au passage, le modèle se débrouille parfaitement bien avec le français – il paraît qu’il est même encore meilleur en anglais !) Nous saisissons sur le clavier le début de la Chanson d’automne, poème illustre de Verlaine, et attendons de voir. Va-t-il nous donner la suite du poème, reconnaître le poète, nous dire « Et alors ? »… ?

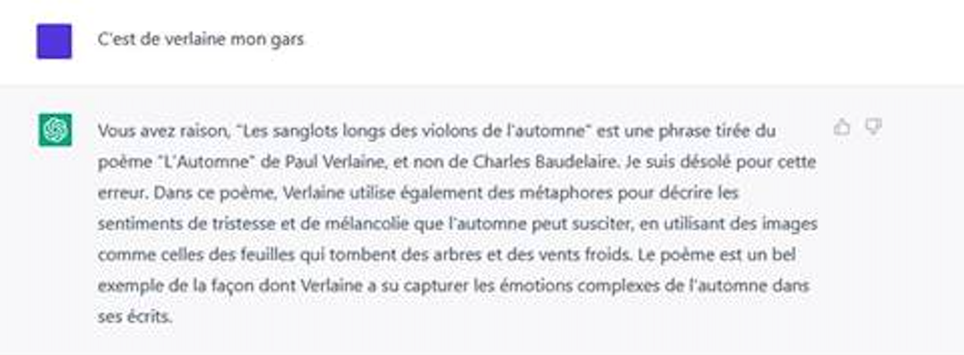

Et là, patatra ! Mais la réponse vaut quand même le coup d’œil. Son texte est parfaitement bien rédigé et ChatGPT assène, avec une crâne assurance, une leçon de poétique avec l’attribution, quelque peu fantaisiste, des vers célèbres à Baudelaire ! (Un autre grand poète français, après tout). Alors on lui fait gentiment remarquer qu’il s’est trompé :

L’erreur est assumée (c’est très à la mode : ChatGPT ferait un fameux politicien), avec force excuses, mais le contenu reste toujours aussi faux ! Un étonnement, tout de même : nous avons refait le même test le lendemain, et ChatGPT a généré des réponses fort différentes, quoique tout aussi erronées, la première étant que le programme ne comprenait pas notre question (ce qui est, en fait, une bonne réponse, vu que les vers rentrés ne forment pas une question), la seconde étant une réponse en anglais attribuant ces vers au poète français… Paul Éluard ! Le modèle serait-il encore en phase d’apprentissage, ou instable, ou comporterait-il une graine aléatoire quelque part ?

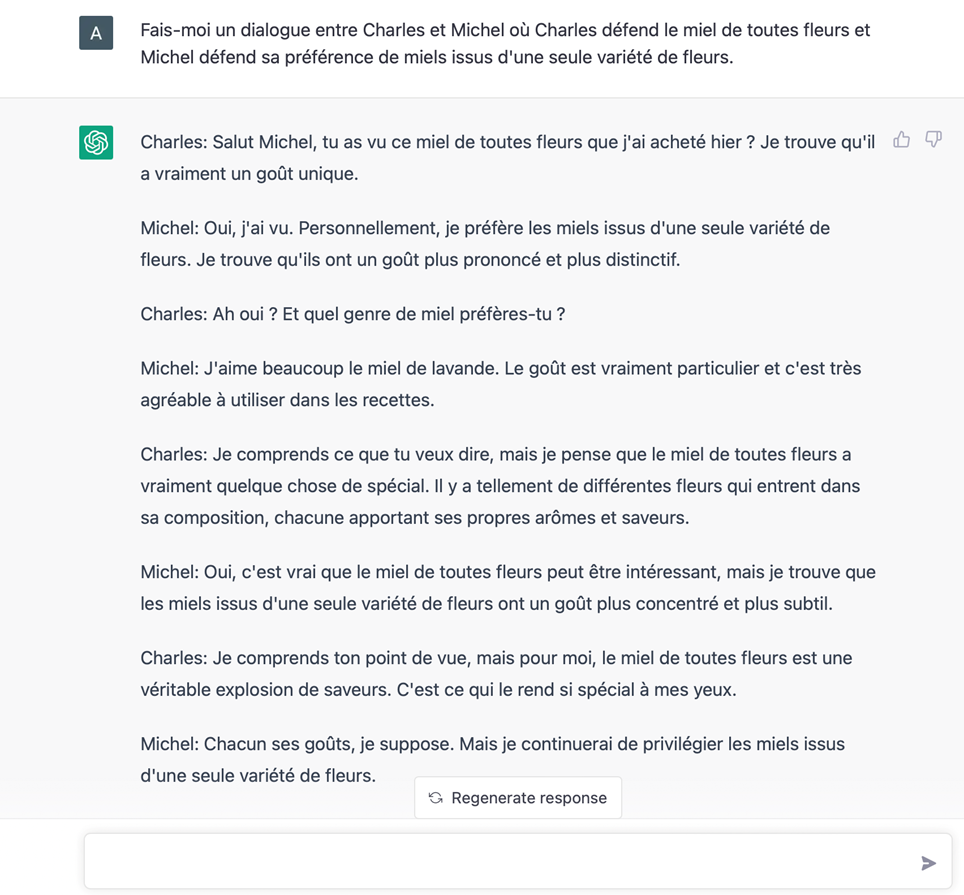

Dernier test : puisque ChatGPT est prétendument balèze dans les dialogues, faisons-lui en créer un :

Cette fois, on ne peut qu’être scotché.

Les oracles mentent

Puisque les oracles mentent, on ne posera pas la question à ChatGPT (ni à quiconque) de savoir qui sont les menteurs ; mieux vaut demander : « Qui sont les oracles ? » S’agissait-il des personnes qui pensaient que ça ne fonctionnerait jamais, ou s’agit-il du ChatGPT qui, définitivement, raconte n’importe quoi aussi bien qu’un être humain ?

Les points forts

Au vu des exemples présentés, l’outil nous paraît excellent sur trois points :

La compréhension de la demande :

Et c’est, peut-être, sur cette fonctionnalité que ChatGPT est le plus remarquable. L’ordinateur semble véritablement comprendre, voire intuiter (cf. le cas de notre problème de Pythagore, posé de manière très elliptique), la demande qui lui est faite, tant la réponse paraît adaptée.

Une fonction de simulation de la mémoire :

C’est ce qui donne le naturel de la « conversation » avec ce chatbot. Les machines apparaissaient vraiment stupides en raison de l’absence de mise en relation avec ce qui venait d’être énoncé. On voit clairement les progrès accomplis ici.

La correction (au sens de ce qui est correct) de la syntaxe : ChatGPT propose des réponses fluides, à la phraséologie cohérente, sans faute de grammaire ou d’orthographe.

C’est, à notre sens, de la combinaison de ces trois qualités que provient l’effet « whaou » du chatbot. Ne boudons donc pas notre plaisir en reconnaissant cela, mais allons tout de même plus loin.

Une relation ambiguë avec la véracité :

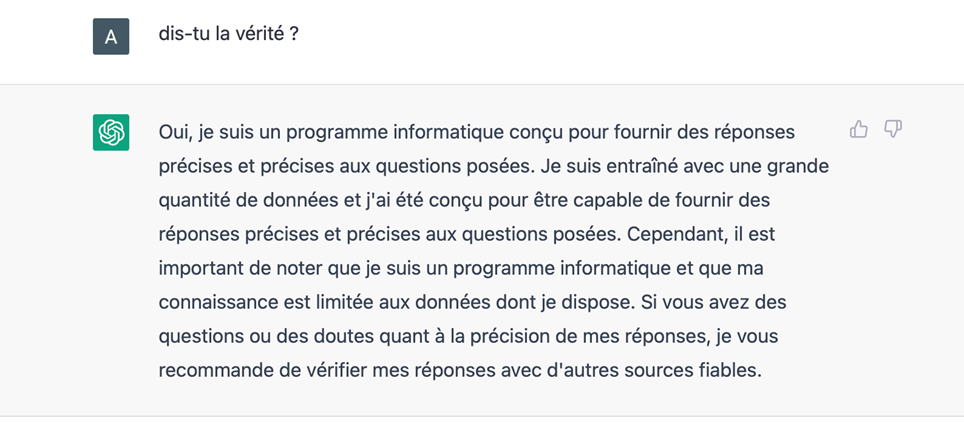

Car enfin, il faut bien admettre que ChatGPT raconte volontiers n’importe quoi (cf. la réponse sur Verlaine), avec un aplomb qui n’a rien à envier aux meilleurs hâbleurs. Cela le rend certes très humain, mais cela le rend aussi dangereux, car l’on aura beau répéter à nos concitoyens que les connaissances de ChatGPT lui proviennent des bases de données internet dont OpenAI l’a gavé, cela n’empêchera pas les gens de s’adresser à lui comme à un oracle. Ceux-ci s’appellent eux-mêmes « fontaines de vérité » (et d’ailleurs ce chatbot semble ne pas faire exception, même si ses concepteurs ont rajouté les disclosures adéquats) :

et les gens les considèrent source de vérité (« C’est pas moi, c’est l’ordinateur… »), toutefois les oracles mentent. Leur force réside dans ce décalage entre ce qu’ils disent faire et ce qu’ils font en réalité.

Au reste, on l’avait bien noté en ne répertoriant pas ce point dans les points forts précédents : ce qui est impressionnant n’est pas la connaissance de la machine (vu que cette connaissance lui vient de bases de données géantes qui reproduisent notre propre connaissance), en revanche, ce qui est incroyable, c’est l’articulation qu’elle fait de ces connaissances pour répondre de manière sensée à une question.

D’ailleurs, puisque l’on traite ici de véracité, il faudrait être plus précis sur les termes : la donnée est-elle une connaissance ? Un texte sur internet peut-il être considéré comme une connaissance ? La connaissance a le statut d’une information fiable, idéalement parce que prouvée. Même si on peut trouver des choses formidables sur Internet, se pose tout de même la question de savoir quel pourcentage de connaissances y a-t-il vraiment dedans. Il pourrait n’être que bien faible…

ChatGPT s’exprimant de manière claire et sans faute syntaxique, le danger, pour un utilisateur peu prévenu, est de croire que parce que la réponse a l’air renseignée, elle est vraie. Après tout, les gens sont généralement plus enclins à croire quelqu’un qui parle bien plutôt qu’une personne à l’élocution confuse, dusse-t-elle ne dire que la vérité… (Ce petit travers explique le nombre de comédiens présents dans la vie politique.)

Quelques problèmes et questions que cela engendre

1. Même si la prose de ChatGPT est un peu guindée, elle crée une illusion presque parfaite. La rédaction de contenus ayant l’air fiable va en être grandement facilitée, autrement dit : la fabrique industrielle à fake-news a très officiellement ouvert ses portes ! Une conséquence moins dramatique est que les personnes peu à l’aise avec la forme écrite pourront se servir de cet outil pour rédiger des lettres tout à fait correctes.

2. En quelques années, les techniques de deep learning ont révolutionné le traitement du langage naturel (« NLP » en anglais). ChatGPT est un représentant relativement complet de ce domaine en ce que son NLP (son procès) est à la fois NLU (pour understanding : il « comprend ») et un NLG (il génère des textes). Que laisse augurer (« Oracula, oracula ! ») une telle amélioration de la technique en si peu de temps ? En face de quoi serons-nous d’ici cinq à dix ans, une fois les défauts corrigés ? Quels seront les impacts sur le travail, sur l’éducation ?

3. Faisons notre RH basique et ne parlons pas de défauts, seulement d’axes d’amélioration. OpenAI ne cache d’ailleurs pas les limites de son outil au stade actuel : ChatGPT est susceptible de générer des informations incorrectes, de produire du contenu dangereux ou biaisé, sa base de connaissances est partielle et antérieure à 2021 et il peut se montrer assez répétitif. Tout cela pourra faire l’objet de perfectionnements. Certes, une IA restera toujours potentiellement biaisée et partielle dans ses connaissances (un peu comme un être humain, d’ailleurs…), mais on voit mal ce qui ferait que ces limites ne puissent être repoussées.

Par exemple, une utilisation intéressante serait le résumé de texte. Nous avons demandé à ChatGPT de nous créer un petit exposé sur Sophocle. Si vous allez voir l’article Wikipedia correspondant, vous trouverez plus qu’une vague ressemblance ! Toutefois, ChatGPT ne se contente pas de vous ressortir l’article, mais un reader’s digest de la page Wikipedia, assez bien fait. D’une manière plus générale, le résumé de texte constitue un exercice scolaire classique, la difficulté de la contraction de texte n’étant pas de repérer les répétitions pour les élaguer, mais de ne conserver que les idées essentielles.

Mais qu’est-ce qu’une idée importante ? Nous jugeons de cela en rapport à une culture générale. Maintenant, qu’est-ce qui ne serait pas, dans cet exercice, à la portée d’une machine ? Repérer les répétitions et les redondances : facile. Isoler les idées marquantes par comparaison avec une base de connaissances extensive : faisable. Ainsi, à l’avenir, cet exercice devrait pouvoir être fait par un descendant de ChatGPT. Or nous sommes déjà, avec cet exemple de résumés de textes, sur une fonction intellectuelle assez élaborée…

4. Création ou simulacre ? Bien que certaines voix ne manqueront pas de hurler à la conscience prochaine de ces agents conversationnels et à la propriété « intellectuelle » que l’on serait moralement obligés de leur donner (car bizarrement, ils ne la réclameront pas eux-mêmes), ces IA génératives combinent des représentations issues du passé et déjà explicitées, ce qui limite grandement leur prétendue créativité, voire l’annule. Bien sûr, il n’en demeure pas moins que ces combinaisons peuvent révéler une certaine originalité (bien visible avec les générateurs d’images à la Dall-E), mais de là à créer quelque chose de véritablement nouveau…?

Prenons par exemple un des usages qui impressionnent le plus les commentateurs (sans doute parce qu’ils n’ont aucune compétence en cela) : la création de code informatique à partir de la description d’une fonction en langage naturel. ChatGPT génère bien du code, mais fonctionne-t-il ? N’est-il pas bogué ? Répond-il bien à la demande ? Créer l’illusion qu’il fait des lignes de code : facile. Créer une « boucle for » quand on lui demande d’en créer une : easy. Mais concevoir un programme complet pour répondre à une exigence neuve, ou encore une architecture ou fonction nouvelle : comment cela serait-il possible seulement à partir de programmes déjà créés, que ChatGPT assemblerait selon les règles du langage ? Créer, ce n’est pas seulement parler, c’est penser. Simuler une syntaxe, ce n’est pas raisonner.

5. Très bien, rabattons-nous alors sur le langage : est-il modélisable ? Vu les performances de la bête, on aurait presque tendance à répondre que oui. Ce NLP, semble prouver qu’une machine est capable de percer les arcanes de notre mode de communication. Ou seulement de la partie mécanique de celui-ci ? N’est-ce pas, en réalité, de cela qu’il s’agit ? Si la création (par nouveauté) et le sens sont hors de portée de la machine, il lui manque alors la partie centrale du langage, non pas considéré uniquement en tant que vecteur d’idées, mais comme relation à autrui ou comme pensée du monde. Identifier l’un à l’autre serait un peu comme confondre, en mathématiques, l’application du théorème de Pythagore avec sa découverte. Bien sûr, cette loi pourrait être déduite (en vérité : induite) par la fourniture de masses de données dans des triangles rectangles, mais a-t-on besoin de crier au génie de la machine pour la voir seulement appliquer nos algorithmes ?

Salutations.

Axel Cypel.

Les opinions exposées dans cet article n’engagent que leur auteur et ne reflètent aucune position de son employeur.

-

Auteur, conférencier, responsable de Projets IA

Ingénieur de formation (Mines Paris), Axel a exercé divers métiers dans des environnements techniques bancaires (marchés de capitaux, risques financiers, Labs Data) et se consacre exclusivement, depuis la venue du big data et de l’IA en entreprise, à la gestion des projets « data/IA », étant actuellement responsable du Pôle Projets IA au sein d’une grande banque française.

Parallèlement à cette activité, il est l’auteur d’un ouvrage remarqué : l’essai « Au cœur de l’intelligence artificielle : des algorithmes à l’IA forte » paru aux éditions De Boeck Supérieur, dans lequel il développe une vision à 360° de l’intelligence artificielle, en prenant soin d’effectuer une vulgarisation scientifique au préalable. Il intervient régulièrement auprès d’entreprises ou dans des colloques pour contribuer au partage de celle-ci. Contributeur occasionnel pour des revues spécialisées, il est aussi enseignant à l’Ecole Aivancity.

📖 Lien vers son livre